Tự động hóa data pipeline với Data Engineering Agent

Trong nhiều năm qua, BigQuery luôn là nền tảng hàng đầu của các doanh nghiệp để phân tích, khai thác những insight quan trọng. Tuy nhiên, việc xây dựng, vận hành và khắc phục sự cố các data pipeline luôn là một quy trình phức tạp, tiêu tốn thời gian và nguồn lực chuyên môn. Chính vì vậy, Google Cloud đã ra mắt giải pháp Data Engineering Agent trong BigQuery nhằm đơn giản hóa các tác vụ phức tạp và tối ưu hiệu suất vận hành. Hãy cùng Cloud Ace tìm hiểu nhé.

Những khó khăn của các giải pháp kỹ thuật dữ liệu truyền thống

Mã hóa thủ công: Xây dựng và điều chỉnh các luồng dữ liệu (pipelines) đòi hỏi nhiều công sức với các truy vấn SQL phức tạp, tốn thời gian và dễ phát sinh lỗi.

Khó khăn trong việc ánh xạ dữ liệu: Việc chuyển đổi dữ liệu từ nhiều nguồn sang đúng định dạng thường tốn nhiều thời gian, đặc biệt khi cấu trúc dữ liệu (schema) thay đổi liên tục.

Xử lý sự cố phức tạp: Chẩn đoán và sửa lỗi trong pipeline thường mất nhiều thời gian rà soát nhật ký và mã nguồn, làm chậm trễ việc thu thập thông tin giá trị.

Phụ thuộc vào chuyên môn cá nhân: Việc xây dựng và bảo trì data pipeline thường yêu cầu kỹ năng chuyên sâu, tạo ra các điểm nghẽn và giới hạn khả năng đóng góp của nhiều người.

Giải pháp BigQuery data engineering agent được phát triển nhằm giải quyết trực tiếp các vấn đề trên, đồng thời đẩy nhanh quá trình xây dựng và quản lý data pipeline một cách hiệu quả.

Lợi ích của BigQuery Data Engineering Agent

1. Tự động hóa việc xây dựng và điều chỉnh data pipeline

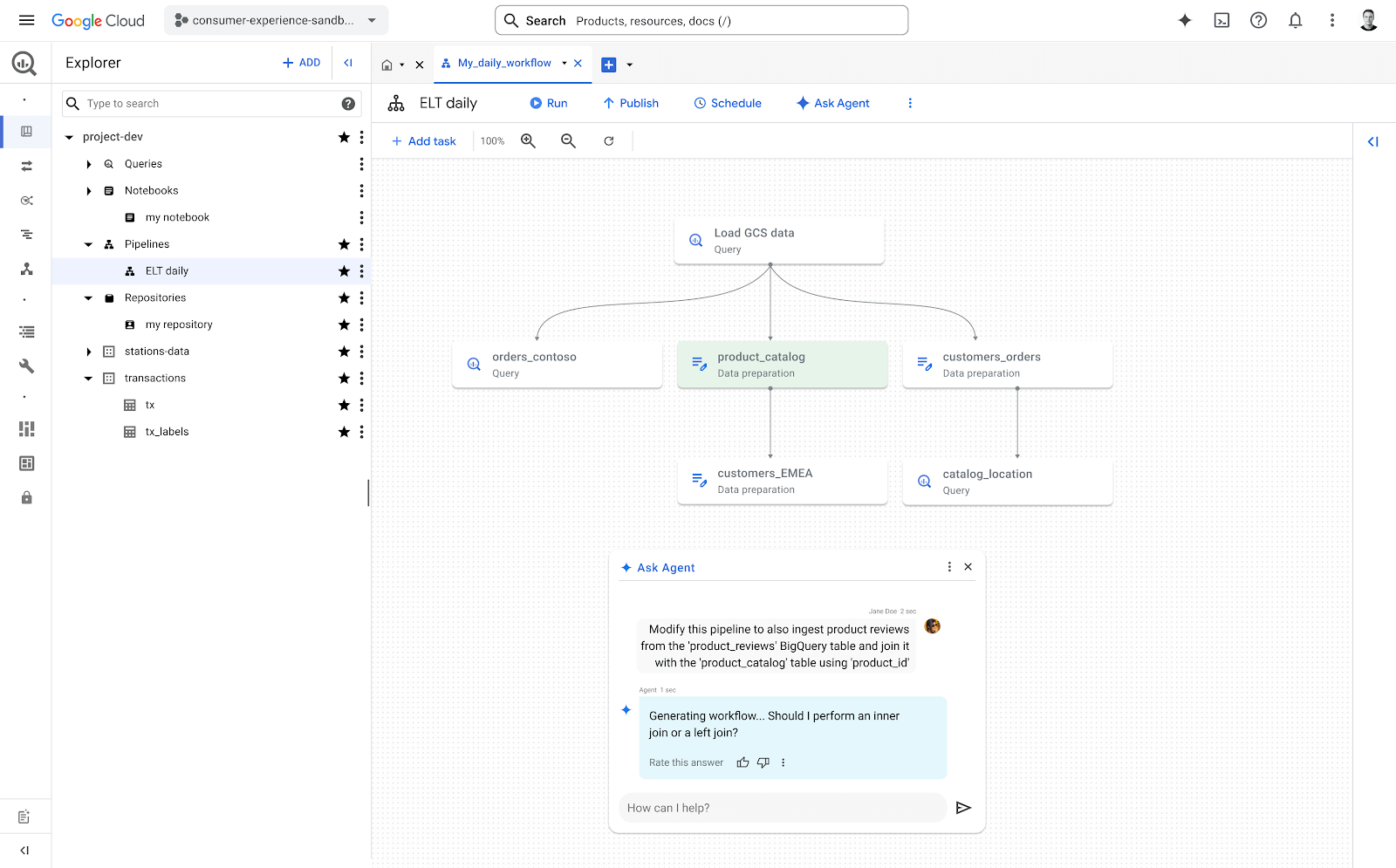

Khi doanh nghiệp cần thiết lập một pipeline mới để thu thập, chuyển đổi và xác thực dữ liệu, chỉ cần mô tả yêu cầu bằng ngôn ngữ tự nhiên – phần còn lại sẽ do Agent xử lý. Ví dụ:

"Tạo pipeline để tải dữ liệu từ 'customer_orders' bucket, chuẩn hóa định dạng ngày, xóa các mục trùng lặp dựa trên ID đơn hàng và tải vào bảng BigQuery có tên 'clean_orders'."

Agent sẽ sử dụng kiến thức chuyên sâu về data engineering cùng khả năng hiểu bối cảnh cụ thể của hệ thống doanh nghiệp để tự động tạo mã SQL, xây dựng pipeline và thiết lập các bài kiểm tra đơn vị cơ bản. Khi cần chỉnh sửa một pipeline hiện có, Agent có thể phân tích code hiện hành, đề xuất các điều chỉnh phù hợp và đánh giá các tác động tiềm ẩn đến quy trình downstream. Doanh nghiệp vẫn giữ toàn quyền kiểm soát, xem xét và phê duyệt thay đổi – trong khi agent sẽ xử lý toàn bộ phần việc kỹ thuật phức tạp.

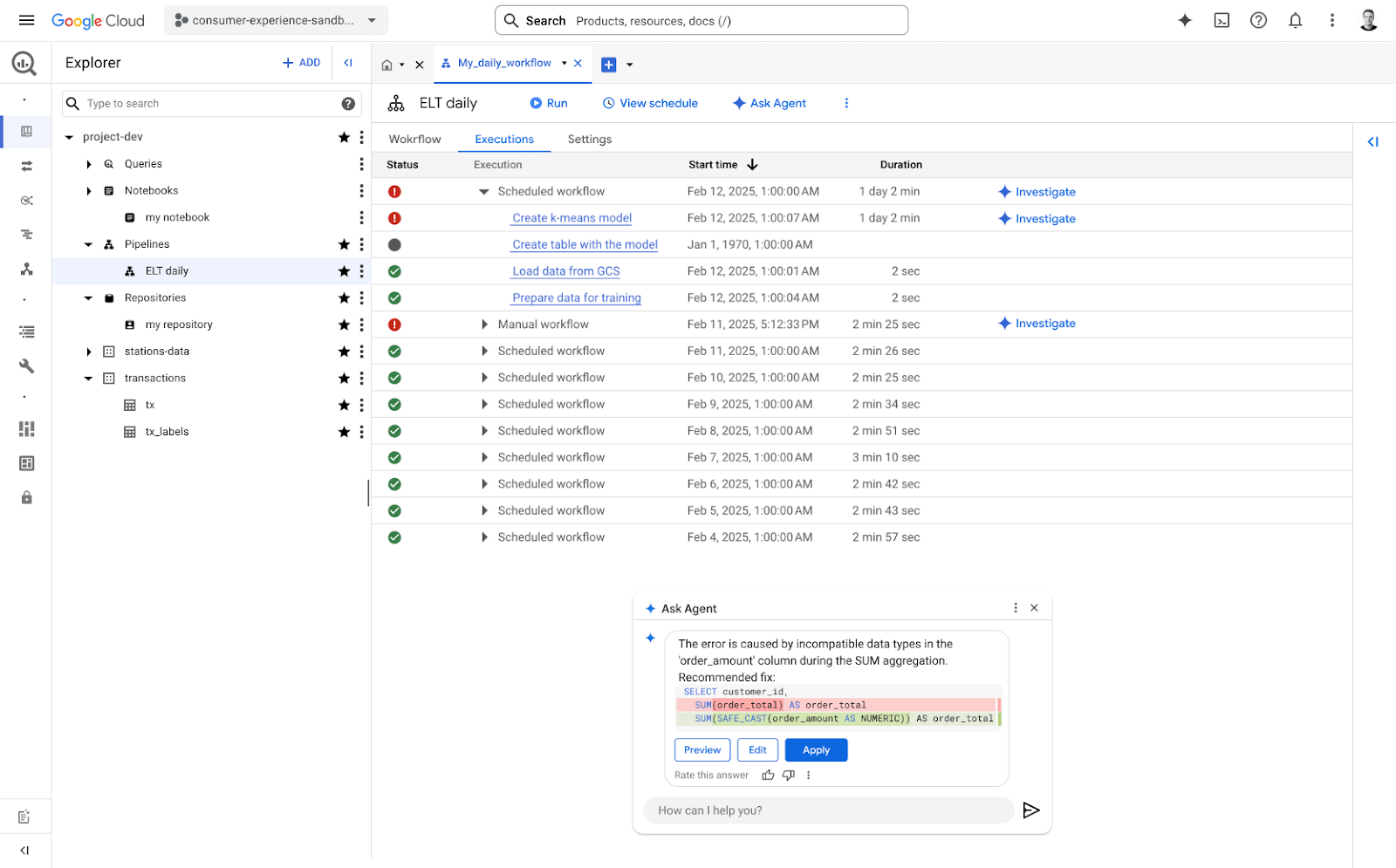

2. Chủ động khắc phục sự cố và tối ưu hóa

Data Engineering Agent chủ động giám sát các pipeline, phát hiện sớm các sự cố như schema và data drift, và đề xuất phương án khắc phục phù hợp. Với vai trò như một chuyên gia kỹ thuật dữ liệu hoạt động liên tục, Agent giúp doanh nghiệp đảm bảo hệ thống vận hành ổn định, giảm thiểu gián đoạn và hỗ trợ duy trì hiệu suất phân tích dữ liệu tối ưu.

3. Tạo hàng loạt pipeline với quy mô lớn

Data Engineering Agent cho phép doanh nghiệp mở rộng quy mô tạo hoặc chỉnh sửa pipeline một cách nhanh chóng bằng cách tận dụng ngữ cảnh và kiến thức đã được học trước đó. Giải pháp này đặc biệt hữu ích khi cần triển khai hàng loạt pipeline cho nhiều phòng ban hoặc các trường hợp sử dụng khác nhau, đồng thời vẫn đảm bảo khả năng tùy chỉnh theo yêu cầu. Việc tự động hóa có thể được thực hiện thông qua dòng lệnh hoặc API, giúp tối ưu quy trình ở cấp độ doanh nghiệp.

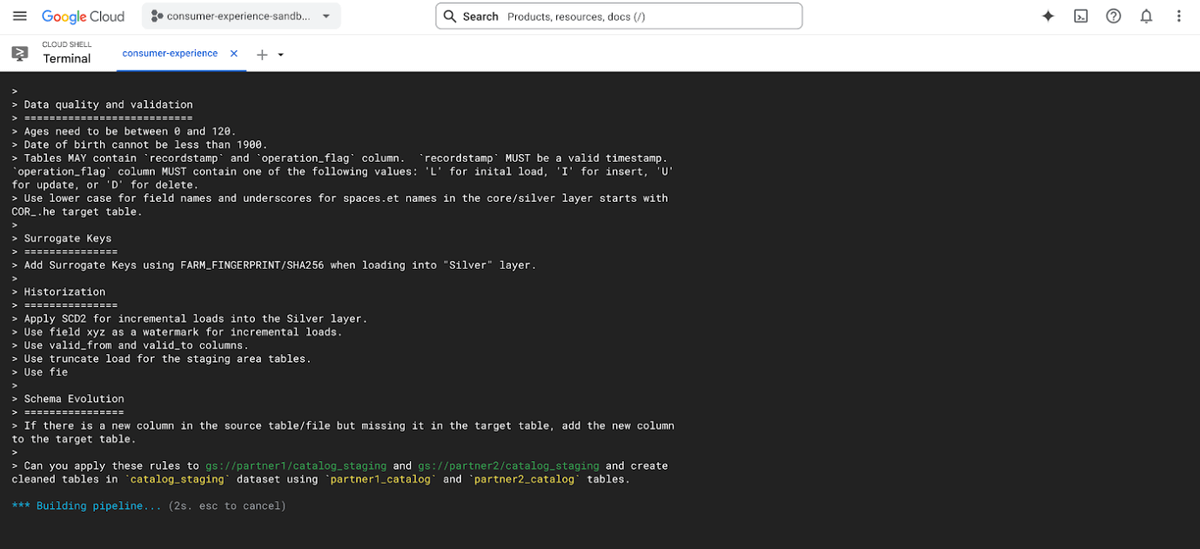

Trong ví dụ minh họa, Agent nhận hướng dẫn từ dòng lệnh và sử dụng chỉ dẫn chuyên biệt theo lĩnh vực để tạo ra các pipeline hàng loạt một cách hiệu quả

Cách thức hoạt động

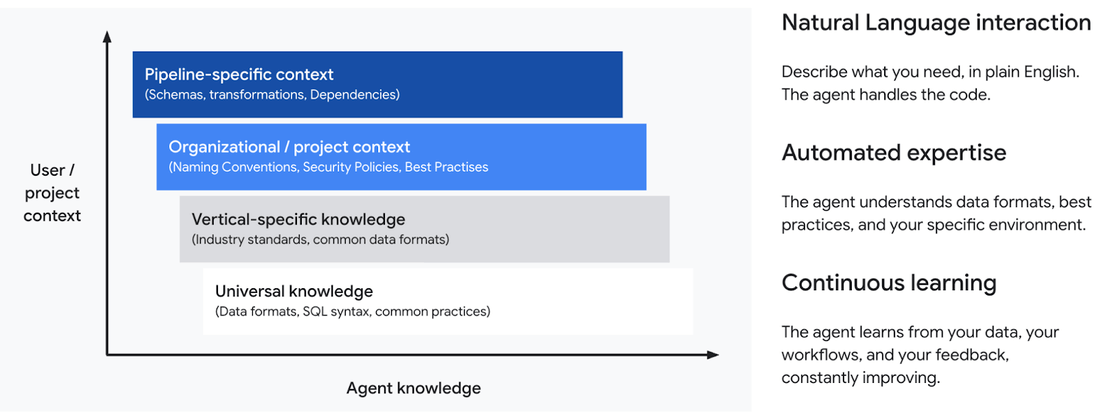

Để đáp ứng độ phức tạp ngày càng cao trong hệ thống dữ liệu doanh nghiệp,Data Engineering Agent vận hành dựa trên hai nền tảng cốt lõi:

🔹 Hiểu ngữ cảnh phân cấp (Hierarchical context): Agent kết hợp thông tin từ nhiều lớp kiến thức:

Kiến thức phổ quát về định dạng dữ liệu, chuẩn SQL và các case study trong ngành dữ liệu.

Kiến thức chuyên ngành, hiểu rõ các quy chuẩn và định dạng dữ liệu đặc thù (ví dụ: ngành y tế, tài chính).

Hiểu biết về tổ chức: cấu trúc dữ liệu, quy ước đặt tên, chính sách bảo mật và ngữ cảnh kinh doanh cụ thể của từng đơn vị.

Nhận diện chi tiết trong pipeline: sơ đồ nguồn – đích, quy trình biến đổi dữ liệu và các mối phụ thuộc kỹ thuật.

🔹 Học tập liên tục (Continuous learning): Agent không chỉ thực thi lệnh mà còn liên tục học hỏi từ quá trình tương tác và các pipeline đã triển khai trước đó. Nhờ đó, kiến thức và khả năng vận hành của tác nhân được cải thiện theo thời gian, phù hợp với môi trường và nhu cầu của doanh nghiệp.

Môi trường hợp tác đa tác nhân

BigQuery data engineering agent là hoạt động trong một môi trường hợp tác gồm nhiều agent chuyên biệt, phối hợp để xử lý các mục tiêu phức tạp. Mỗi agent đảm nhiệm một vai trò cụ thể:

▪️ Tác nhân nhập dữ liệu (Ingestion Agent): Quản lý hiệu quả việc tiếp nhận dữ liệu từ nhiều nguồn khác nhau.

▪️ Tác nhân chuyển đổi dữ liệu (Transformation Agent): Xây dựng pipeline dữ liệu tối ưu và đáng tin cậy.

▪️ Tác nhân xác thực (Validation Agent): Đảm bảo tính chính xác và nhất quán của dữ liệu.

▪️ Tác nhân xử lý sự cố (Troubleshooting Agent): Chủ động phát hiện và khắc phục sự cố trong quá trình vận hành pipeline.

▪️ Tác nhân giám sát chất lượng dữ liệu (Data Quality Agent): Sử dụng metadata từ Dataplex để theo dõi dữ liệu và cảnh báo bất thường.

Trọng tâm ban đầu của Google Cloud là các hoạt động thu nạp, chuyển đổi và xử lý sự cố. Tuy nhiên, lộ trình phát triển sẽ tiếp tục mở rộng để bao phủ toàn bộ các hoạt động cốt lõi trong kỹ thuật dữ liệu doanh nghiệp.

Cloud Ace - Managed Service Partner của Google Cloud

- Trụ sở: Tòa Nhà H3, Lầu 1, 384 Hoàng Diệu, Phường 9, Quận 4, TP. HCM.

- Văn phòng đại diện: Tầng 2, 25t2 Hoàng Đạo Thúy, Phường Trung Hoà, Quận Cầu Giấy, Thành phố Hà Nội.

- Email: sales.vn@cloud-ace.com

- Hotline: 028 6686 3323

- Website: https://vn.cloud-ace.com/